Sistemas Operacionais e Redes: Gerência de Processos e Threads

Introdução: Uma Jornada ao Coração do Seu Computador

Já parou para pensar em como seu computador, smartphone ou qualquer outro dispositivo digital consegue fazer tantas coisas ao mesmo tempo? Você ouve música enquanto escreve um e-mail, navega na internet, e ainda por cima, mantém dezenas de janelas abertas. Nos bastidores, existe uma complexa coreografia digital que torna toda essa mágica possível. O sistema operacional atua como o maestro de uma grande orquestra, e as notas musicais são os processos e as threads. O resultado dessa sinfonia é a eficiência e a estabilidade que você experimenta diariamente.

Para entender essa sinfonia digital, é preciso desvendar a lógica por trás da gerência de processos e threads. Este guia foi preparado para simplificar esses conceitos, transformando o que parece um mistério técnico em um conhecimento divertido e acessível. Ao longo da leitura, você descobrirá como o seu dispositivo lida com a concorrência de tarefas, aloca recursos e mantém tudo funcionando sem problemas, da mesma forma que um maestro guia sua orquestra.

Processos e Threads: Os Heróis de Sistemas Operacionais e Redes

Para começar nossa jornada, a melhor forma de entender a gerência de processos e threads é por meio de uma analogia simples. Imagine que seu computador é uma cozinha digital super equipada, e o sistema operacional é o chef principal, que garante que todas as receitas sejam preparadas com sucesso.

O que é um Processo? A Receita de Bolo do Seu PC

Um processo é, de forma muito simples, um programa em execução. Da mesma forma que uma receita de bolo, ele contém tudo o que é necessário para ser executado: a sequência de instruções (a receita) e os recursos para fazê-lo (os ingredientes, a batedeira, o forno etc.). Além disso, cada processo opera em seu próprio “espaço de cozinha” virtual. A memória de um processo é isolada, o que significa que o seu programa de

videogame não pode simplesmente invadir o espaço do seu editor de texto, garantindo a estabilidade e a segurança do sistema. Essa separação é fundamental, pois se um processo falhar, ele não afeta os outros que estão em execução.

E o que é uma Thread? O Ajudante do Chefe de Cozinha

Agora, imagine que para acelerar a preparação do bolo, o chef principal chame um ou mais ajudantes. É exatamente isso que as threads fazem. Uma thread (ou “fio”, em uma tradução literal) é a menor unidade de execução gerenciada por um sistema operacional. Várias

threads podem rodar dentro do mesmo processo, trabalhando em diferentes partes da “receita” ao mesmo tempo. Por isso, as

threads são frequentemente chamadas de “processos leves”. Elas são mais rápidas de serem criadas e alternadas do que os processos, mas, em contrapartida, compartilham o mesmo espaço de memória e os recursos do processo pai. Esse compartilhamento é o que permite que elas trabalhem em conjunto de forma tão eficiente.

Então, Qual a Diferença entre os Dois? Uma Analogia para Não Esquecer

Por conseguinte, a principal distinção está no nível de independência e compartilhamento. Observe o resumo na lista abaixo:

- Processo: É a cozinha inteira. Tem sua própria área de trabalho (memória) e seus próprios equipamentos (recursos). A comunicação com outras cozinhas (IPC) exige mecanismos específicos.

- Thread: É o ajudante dentro da cozinha. Não tem sua própria cozinha, mas compartilha a área de trabalho e os equipamentos do processo pai. A comunicação é mais rápida e direta, pois os ajudantes podem simplesmente conversar entre si na mesma cozinha.

O Ciclo de Vida de Processos: Uma História de Vida Curta (e Digital)

Ainda que a analogia seja divertida, os processos, assim como seres vivos, têm um ciclo de vida. Eles nascem, “crescem”, trabalham e, por fim, morrem. Para gerenciar essa vida, o sistema operacional monitora cada passo, garantindo que os recursos do sistema, como o processador (CPU), sejam distribuídos de forma justa e eficiente. Para gerenciar os processos e seus estados, o sistema operacional mantém informações sobre todos os processos presentes na memória. Isso é crucial para que o agendador de processos possa tomar decisões informadas sobre qual processo terá acesso à CPU.

O Ciclo de Vida em Ação

O modelo mais comum de ciclo de vida de um processo possui cinco estados principais. Cada estado representa uma fase na existência do processo.

- Estado Novo: Este é o estado inicial. O processo acabou de ser criado, mas ainda não está pronto para ser executado. O sistema operacional está ocupado alocando os recursos necessários para que ele comece a trabalhar, como o espaço na memória principal.

- Estado Pronto (Ready): O processo já tem todos os recursos que precisa e está esperando a sua vez de usar o processador. Processos nesse estado ficam em uma fila, aguardando pacientemente que o “maestro” os chame para a ação.

- Estado Em Execução (Running): Finalmente, o processo está utilizando a CPU. Suas instruções estão sendo executadas. Em um sistema com um único núcleo de processamento, apenas um processo pode estar no estado Em Execução a cada momento.

- Estado Em Espera (Waiting/Blocked): O processo precisa de algo para continuar. Ele pode estar esperando por uma entrada do usuário, por uma informação que está em um disco rígido ou pela conclusão de uma operação de rede. Quando o que ele precisa estiver disponível, ele volta para a fila de Pronto.

- Estado Terminado: O processo concluiu sua tarefa, ou foi encerrado por algum motivo. O sistema operacional agora está no processo de desalocar todos os recursos que ele estava utilizando.

A seguir, a tabela detalha o que acontece em cada um desses estágios:

| Estado | O que significa? | Exemplo |

| Novo | O processo está sendo criado e seus recursos, como memória, estão sendo alocados. | Você acabou de clicar duas vezes no ícone de um programa. |

| Pronto | O processo está na fila, aguardando sua vez de ser executado pela CPU. | O programa já foi carregado na memória e está pronto para rodar. |

| Em Execução | O processo está ativamente usando a CPU e suas instruções estão sendo processadas. | O processador está calculando dados para exibir uma página web. |

| Em Espera | O processo foi temporariamente suspenso, esperando por um evento externo. | O programa está esperando você digitar algo ou o mouse mover. |

| Terminado | A execução do processo foi concluída e seus recursos estão sendo liberados. | Você fechou o programa, ou ele finalizou sua tarefa. |

Exportar para as Planilhas

O Agendamento de Processos e Threads: O Maestro da Orquestra Digital

O segredo por trás da multitarefa, ou seja, a capacidade do computador de executar várias tarefas ao mesmo tempo, está no agendamento. O “agendador” de processos, ou escalonador, é o subsistema do sistema operacional responsável por decidir qual processo, ou thread, terá a honra de usar a CPU em determinado momento. O objetivo principal é garantir que a CPU nunca fique ociosa e que as tarefas sejam executadas de forma eficiente, enquanto o sistema se mantém responsivo para o usuário.

A escolha do algoritmo de escalonamento envolve uma série de trade-offs entre a justiça, a eficiência e a capacidade de resposta. Cada um dos algoritmos foi projetado com um objetivo específico em mente.

Algoritmos de Escalonamento que Cuidam da Gerência de Processos e Threads

Afinal, a gerência de processos e threads depende fortemente de como o agendador toma suas decisões. Apresentaremos alguns dos algoritmos mais comuns.

- First-Come, First-Served (FCFS): O mais simples dos algoritmos. Funciona exatamente como uma fila de supermercado: o primeiro processo a chegar é o primeiro a ser atendido. Uma vez que um processo começa, ele continua a ser executado até o fim. Embora seja fácil de entender, o FCFS pode sofrer do “efeito comboio” (convoy effect), onde um único processo longo pode fazer com que todos os outros processos na fila, mesmo os curtos, esperem por um longo período.

- Round-Robin (RR): Mais justo e eficaz para sistemas de tempo compartilhado. Cada processo recebe uma pequena “fatia de tempo” (quantum). Se a tarefa não for concluída nesse tempo, ela é interrompida e enviada para o final da fila, dando a próxima tarefa sua chance. Este ciclo se repete até que todas as tarefas sejam concluídas. O Round-Robin garante que nenhum processo seja deixado para trás e que o sistema seja percebido como sendo altamente responsivo.

- Shortest Job First (SJF): Este algoritmo prioriza a eficiência, sempre escolhendo o processo com o menor tempo de execução restante para ser executado. O SJF tem a vantagem de minimizar o tempo de espera médio, mas enfrenta um grande desafio na prática: é quase impossível saber de antemão qual processo tem o menor tempo de execução sem prever o futuro.

Comunicação entre Processos e Threads: Conversando para Ajudar

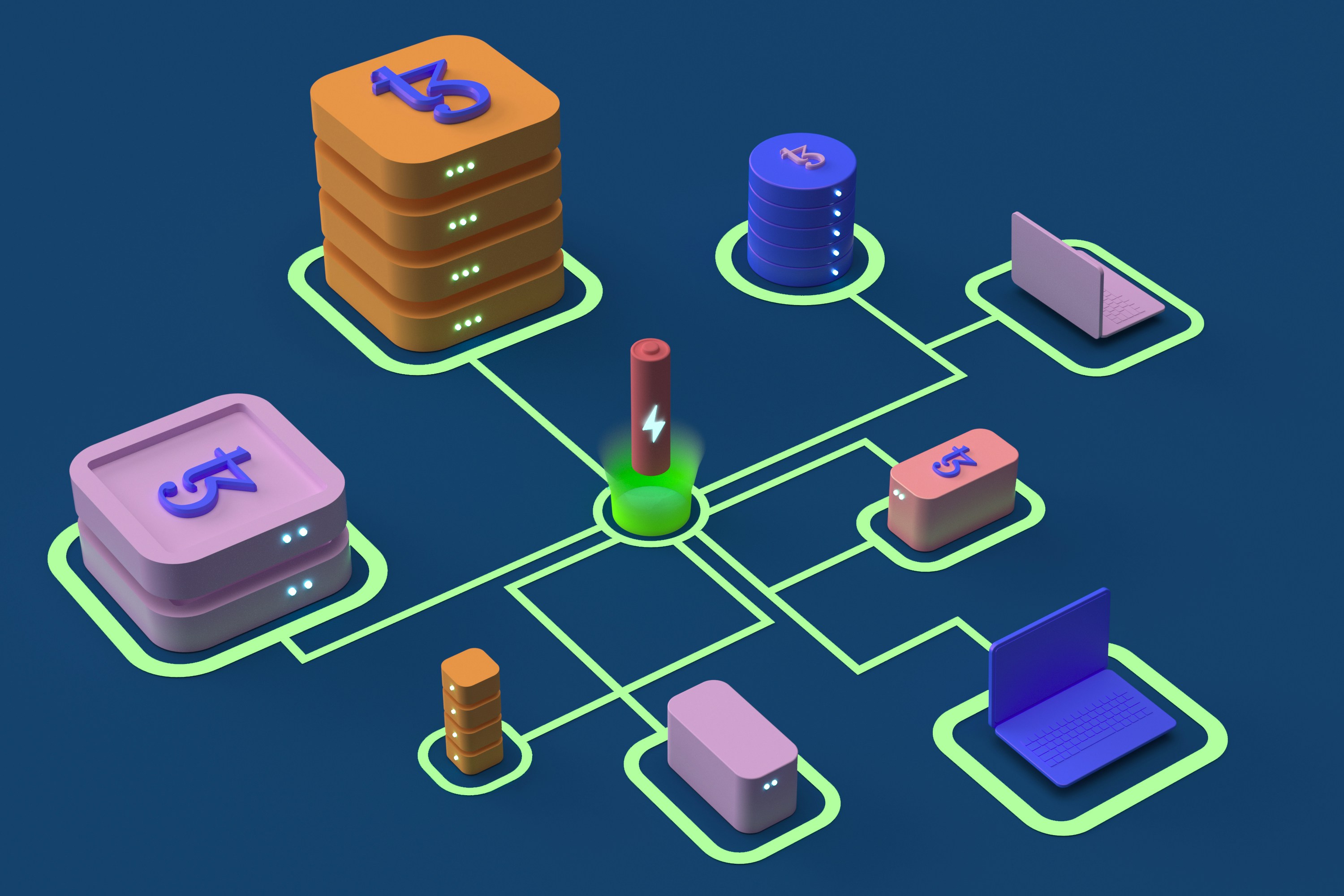

Já que os processos são entidades isoladas com suas próprias memórias, eles precisam de mecanismos especiais para trocar informações. Essa comunicação é conhecida como Comunicação Inter-Processos ou IPC, do inglês Inter-Process Communication.

A comunicação entre processos é um tópico fundamental, visto que a maioria dos sistemas modernos é composta por diversos processos que precisam cooperar. Por exemplo, o seu navegador web pode ser um processo, e o plugin que exibe um vídeo pode ser outro, e eles precisam conversar. Além do mais, a escolha do mecanismo de IPC depende muito do tipo de comunicação necessária:

- Pipes: A forma mais antiga e simples de IPC. Pense em um pipe como um cano unidirecional que conecta dois processos. Um processo escreve dados em uma extremidade do cano, e o outro lê na outra. Eles são úteis para comunicação entre processos que estão diretamente relacionados, como um processo pai e um processo filho.

- Memória Compartilhada (Shared Memory): Este é o mecanismo mais rápido de IPC. Ele permite que diferentes processos acessem uma mesma área de memória. A troca de dados se torna extremamente rápida, pois não há necessidade de copiar informações. No entanto, o seu uso requer um cuidado especial, pois se mais de um processo tentar escrever na mesma área ao mesmo tempo, pode haver problemas de inconsistência nos dados.

- Sockets: São mecanismos que permitem a comunicação entre processos que podem estar em máquinas diferentes, conectados por uma rede de computadores. São a base de toda a comunicação na internet e em redes locais, sendo o mecanismo que permite que seu navegador se comunique com um servidor web em outro continente.

Gerência de Processos e Threads em Servidores Web: Por que isso é Importante para a Internet?

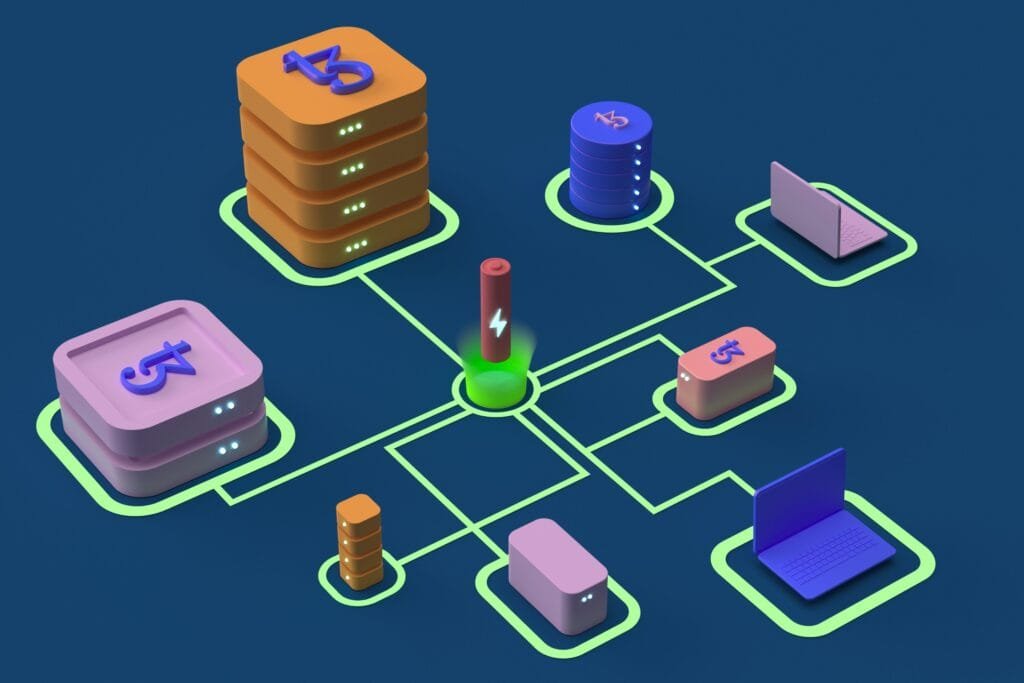

No contexto da internet, a gerência de processos e threads é a espinha dorsal de qualquer servidor web que atenda a milhares de requisições simultâneas. Servidores precisam ser capazes de lidar com a concorrência de forma eficiente para manter a velocidade e a estabilidade. Por essa razão, a escolha da arquitetura é fundamental.

Geralmente, há dois modelos principais para lidar com a concorrência: o modelo multi-processo e o multi-thread. O modelo de multi-processo aloca um novo processo para cada requisição, garantindo isolamento total, o que o torna mais robusto. Já o modelo multi-thread é mais leve e eficiente, pois várias

threads podem atender a múltiplas requisições dentro do mesmo processo.

Essa diferença é crucial. Um servidor multi-processo é mais adequado para tarefas que exigem muita CPU (como processamento de dados intensivo), pois cada processo tem sua própria CPU, permitindo um paralelismo real. Por outro lado, um servidor multi-thread é ideal para tarefas que são “vinculadas a I/O” (

I/O-bound), como esperar por uma resposta de rede ou acesso a um banco de dados. Enquanto uma

thread aguarda, o sistema operacional pode rapidamente alocar a CPU para outra thread que está pronta para trabalhar. A maioria dos servidores modernos utiliza threads por sua eficiência em gerenciar a espera por dados, uma atividade comum no ambiente web.

EXEMPLO PRÁTICO: Conflitos de Threads e a Solução com Sincronização

Um dos maiores desafios da gerência de processos e threads em ambientes multi-thread é o que conhecemos como condição de corrida (race condition). Este problema ocorre quando várias

threads tentam acessar e modificar um mesmo recurso compartilhado ao mesmo tempo, levando a resultados imprevisíveis e incorretos.

Vamos voltar à nossa analogia da cozinha digital. Imagine dois ajudantes (as threads) em uma mesma cozinha (o processo). Há um contador de ovos em uma lousa, que mostra o número total de ovos usados. Um dos ajudantes lê o número 100, mas antes que ele possa escrever o novo valor (101), o outro ajudante lê o mesmo número 100 e escreve 101. O primeiro ajudante, então, finalmente escreve 101, resultando em um erro: a contagem final deveria ser 102, mas foi 101. Isso acontece porque a operação de “somar um” não é atômica, ou seja, ela é dividida em várias etapas: ler o valor, somar um, e escrever o novo valor.

A solução para esse problema é a sincronização. Ao usar um mecanismo de lock (ou “cadeado”), garantimos que apenas uma thread por vez possa acessar e modificar o recurso compartilhado.

ALERTA: Para os interessados em realizar o exemplo prático, é fundamental que o código seja executado em um ambiente de desenvolvimento seguro, previamente destinado a isso, e sob a sua inteira responsabilidade.

Código de Exemplo: Resolvendo uma Condição de Corrida com Locks

A seguir, apresentamos um código simples em Python que ilustra o problema da condição de corrida e, em seguida, a solução com a utilização de um Lock para garantir que a operação de incremento seja segura.

Python

# Importa o módulo threading

import threading

# Recurso compartilhado

contador = 0

# Cria um objeto Lock para sincronizar o acesso

lock = threading.Lock()

def incrementar():

"""Função que incrementa o contador."""

global contador

for _ in range(100000):

# O problema: operação não-atômica

# Sem o lock, a contagem final será inconsistente

# contador += 1

# A solução: usa o lock para garantir acesso exclusivo

with lock:

contador += 1

# Lista para armazenar as threads

threads =

# Cria 5 threads

for _ in range(5):

t = threading.Thread(target=incrementar)

threads.append(t)

t.start()

# Espera todas as threads terminarem

for t in threads:

t.join()

# O valor final será sempre o esperado, 500000

print(f"Valor final do contador: {contador}")

O comando with lock: assegura que o bloco de código dentro dele seja executado por apenas uma thread por vez. Isso resolve a condição de corrida e garante que a contagem final seja sempre a correta, pois o acesso ao recurso compartilhado é protegido.

Fluxograma e Gráficos: O Caminho Visual da Gerência de Processos e Threads

Os conceitos de estados e transições podem ser visualizados de forma clara em um diagrama. A representação visual de um processo durante sua existência ajuda a solidificar o entendimento de como o sistema operacional gerencia as tarefas.

A seguir, um fluxograma simplificado do ciclo de vida de um processo:

Snippet de código

graph TD

A[Novo] --> B(Pronto)

B --> C{Agendador}

C --> B

C --> D(Em Execução)

D --> E{Evento?}

E --> F(Terminado)

E --> B

E --> G(Em Espera)

G --> B

Além disso, a diferença de desempenho entre aplicações de um único thread e multi-thread em tarefas I/O-bound é notável. Em uma representação gráfica, poderíamos ver uma linha representando uma aplicação de único thread que, ao fazer uma operação de I/O, como uma requisição de rede, mostra um “buraco” na utilização da CPU, pois o sistema fica parado esperando a resposta. Em contrapartida, um gráfico de uma aplicação multi-

thread mostraria uma utilização de CPU quase contínua, pois enquanto uma thread aguarda, o processador é imediatamente usado por outra thread, maximizando o desempenho.

O Futuro da Gerência de Processos e Threads: De Otimização a Tendências

A compreensão de como o computador gerencia tarefas é mais relevante hoje do que nunca. A gerência de processos e threads não é apenas um conceito fundamental da computação, mas também é a base para as tecnologias mais avançadas. Assim, essas tecnologias dependem diretamente de uma alocação de recursos eficiente.

- Inteligência Artificial (IA) e Aprendizado de Máquina: Os modelos de IA são intensivos em CPU. A execução de cálculos complexos em paralelo depende de uma gerência de processos e threads robusta, que distribui a carga de trabalho de forma eficiente entre múltiplos núcleos de processadores.

- Computação em Nuvem (Cloud Computing): Os serviços em nuvem, como a Amazon Web Services ou o Google Cloud, vendem poder de processamento. A eficiência no gerenciamento de processos e threads é crucial para a escalabilidade e a otimização de custos, garantindo que os clientes obtenham o máximo de desempenho de seus recursos.

- Cibersegurança: O controle de processos é um pilar da segurança de sistemas. Ferramentas como AppArmor e SELinux no Linux usam perfis para restringir o que os processos podem fazer, limitando seu acesso a arquivos e redes, e por conseguinte, prevenindo ataques e atividades maliciosas.

Conclusão e Resumo: O Ponto Final da Nossa Jornada Digital

Por fim, o universo da gerência de processos e threads pode parecer complexo, mas é a base sobre a qual todos os nossos sistemas computacionais foram construídos. Da orquestra de um computador pessoal aos bastidores de um servidor web, o trabalho do sistema operacional para agendar tarefas, resolver conflitos e garantir uma comunicação eficiente é o que nos permite desfrutar de uma experiência digital fluida e segura. Ao entender como seu dispositivo funciona por dentro, você não apenas adquire um conhecimento técnico valioso, mas também desenvolve uma nova apreciação pela complexidade e engenhosidade dos sistemas que usamos diariamente.

NOTA TÉCNICA: Processo: Programa em execução, com memória isolada. Thread: Unidade de execução leve, compartilha memória do processo. Escalonamento: Decisão sobre qual processo usa a CPU. Algoritmos: FCFS, Round-Robin, SJF. Comunicação: IPC (ex: Pipes, Memória Compartilhada, Sockets). Concorrência: Execução de múltiplas tarefas ao mesmo tempo. Race Condition: Conflito de dados em recursos compartilhados. Sincronização: Uso de Locks para resolver conflitos.

Sistemas Operacionais e Redes: Arquitetura de Sistemas Operacionais