O que é Probabilidade e Estatística?

A probabilidade e a estatística são dois ramos fundamentais da matemática que desempenham papéis cruciais em diversas áreas, incluindo a rede de computadores. A probabilidade é a matemática da incerteza, que se refere à análise da chance de ocorrência de eventos. Este campo permite avaliar a frequência esperada de eventos sob condições específicas, fornecendo um arcabouço teórico para entender fenômenos aleatórios. Por exemplo, calcular a probabilidade de um pacote de dados ser perdido em uma rede pode ajudar na tomada de decisões para melhorar a confiabilidade da comunicação.

Por outro lado, a estatística é o ramo da matemática que envolve a coleta, organização, interpretação e apresentação de dados. Através de métodos estatísticos, os profissionais podem extrair informações significativas de conjuntos de dados, permitindo uma compreensão mais profunda e decisões informadas. No contexto das redes de computadores, a estatística é empregada para monitorar o desempenho da rede e otimizar processos, utilizando dados de tráfego para ajustar configurações ou prever problemas antes que ocorram.

A inter-relação entre probabilidade e estatística é fundamental. Enquanto a probabilidade fornece um modelo matemático das incertezas, a estatística oferece o método para validar esses modelos na prática. Juntas, essas disciplinas apoiam a análise e a melhoria de sistemas de rede. Por exemplo, ao avaliar a performance de protocolos de comunicação, os engenheiros de rede podem usar a probabilidade para prever falhas, enquanto a estatística pode ajudar a quantificar a frequência dessas falhas em diferentes condições de operação.

Portanto, tanto a probabilidade quanto a estatística são ferramentas indispensáveis para profissionais que buscam garantir a eficiência e segurança em redes de computadores, tornando-se essencial para qualquer análise que vise promover a excelência operacional neste campo.

A Importância da Probabilidade nas Redes de Computadores

A probabilidade desempenha um papel fundamental nas redes de computadores, especialmente quando se considera a natureza incerta e dinâmica dessa infraestrutura. Em um ambiente onde múltiplos fatores podem influenciar a comunicação dos dados, a aplicação de conceitos probabilísticos se torna essencial para a avaliação e a gestão de riscos. Assim, a probabilidade não apenas ajuda a modelar esses riscos, mas também fornece uma base sólida para tomar decisões informadas e estratégicas.

Um dos principais usos da probabilidade nas redes é na análise de desempenho. Por exemplo, ao projetar um sistema de rede, os engenheiros devem considerar a probabilidade de falhas de equipamentos, perda de pacotes e latência na transmissão de dados. Esses fatores podem impactar significativamente o desempenho geral da rede. Utilizando estatísticas e distribuições de probabilidade, os profissionais podem prever cenários e implementar medidas mitigatórias, minimizando interrupções e maximizando a eficiência.

Além da performance, a segurança das redes de computadores também se beneficia do uso de probabilidade. Ataques cibernéticos podem ser modelados como eventos probabilísticos, onde a chance de sucesso varia dependendo de diversos fatores, como vulnerabilidades do sistema e comportamento do usuário. Através da análise de probabilidade, é possível identificar áreas de risco e priorizar ações de segurança, aplicando recursos de forma eficaz para proteger dados e integridade do sistema.

Exemplos práticos incluem a análise de tráfego na rede, onde se avaliam padrões e anomalias. Ao aplicar métodos estatísticos e probabilísticos, as organizações conseguem detectar e responder a incidentes de segurança em tempo real, melhorando a resiliência da rede. Portanto, a probabilidade se mostra indispensável na construção de redes de computadores robustas e seguras, fundamentadas em decisões baseadas em dados e análises concretas.

Conceitos Estatísticos Fundamentais

A estatística é uma disciplina que se mostra essencial na análise de redes de computadores, pois fornece as ferramentas necessárias para interpretar dados de maneira eficaz. Entre os conceitos mais relevantes estão a média, a mediana, a moda, a variância e o desvio padrão. Cada um desses termos oferece uma perspectiva única sobre os dados coletados em uma rede.

A média, ou expectativa aritmética, é calculada somando todos os valores e dividindo pelo número total de observações. Este conceito é útil para determinar o valor central de um conjunto de dados, como a latência média de pacotes em uma rede, permitindo uma rápida avaliação do desempenho geral.

Por outro lado, a mediana representa o número que divide um conjunto de dados em duas partes iguais. Quando os dados são distribuídos de forma assimétrica, a mediana fornece uma visão mais precisa da centralidade, já que não é afetada por valores extremos. Essa característica a torna um recurso valioso na análise de tempos de resposta, onde outliers podem distorcer a média.

A moda é o valor que aparece com maior frequência em um conjunto de dados. Em um contexto de rede, identificar a moda pode ajudar a compreender padrões comuns de tráfego e uso, oferecendo insights sobre a experiência do usuário e a carga da rede.

Por último, a variância e o desvio padrão medem a dispersão dos dados em relação à sua média. A variância calcula a média dos desvios quadráticos das observações, enquanto o desvio padrão é a raiz quadrada da variância. Ambas as métricas são cruciais para entender a estabilidade do desempenho da rede; uma alta variância ou desvio padrão indica flutuações significativas que podem afetar a confiabilidade do serviço.

Em resumo, a compreensão desses conceitos estatísticos fundamentais é vital para qualquer análise eficaz de dados em redes de computadores, permitindo a identificação de tendências e necessidades de otimização.

Você também pode se interessar por: Rede de Computadores: Inglês Técnico para Ti

Aplicações Práticas da Estatística em Redes

A estatística desempenha um papel fundamental no gerenciamento e na otimização das redes de computadores, possibilitando uma análise detalhada e a tomada de decisões informadas. Um dos principais usos da estatística em redes é o monitoramento de desempenho. Por meio da coleta de dados estatísticos sobre largura de banda, latência e perda de pacotes, administradores podem identificar gargalos e comportamentos anormais que comprometam a eficiência da rede. Ferramentas de monitoramento estatístico ajudam a visualizar essas métricas, permitindo uma resposta rápida a potenciais problemas.

A análise de tráfego é outra aplicação significativa da estatística em ambientes de rede. O tráfego de dados pode ser modelado e analisado para entender padrões de uso, prever congestionamentos e otimizar a alocação de recursos. Técnicas como análise de séries temporais e regressão podem ser empregadas para prever picos de tráfego em momentos específicos, permitindo que as equipes de TI realizem ajustes proativos na configuração da rede. Essa previsão não apenas melhora a experiência do usuário final, mas também promove uma utilização mais eficiente dos recursos disponíveis.

Além dessas, a estatística é essencial na previsão de falhas dentro das redes de computadores. Por meio da análise de dados históricos, algoritmos estatísticos podem ser utilizados para identificar padrões que precedem falhas de hardware ou software. Este tipo de análise preventiva permite às organizações implementar intervenções antes que ocorra uma falha catastrófica, resultando em alta disponibilidade e confiabilidade da rede. Assim, a integração dos princípios estatísticos na dinâmica diária das redes traz benefícios substanciais, promovendo uma infraestrutura mais robusta e resiliente.

Exemplo Prático

Para demonstrar a aplicação de matemática, probabilidade e estatística em redes de computadores, consideraremos um cenário prático em que monitoramos a latência de pacotes em uma rede. A latência, que é o tempo que um pacote leva para ir de um ponto a outro na rede, pode ser influenciada por diversos fatores, como congestionamento da rede, qualidade dos equipamentos e distância entre os pontos de medição.

Supondo que desejamos medir a latência de um roteador a um servidor em um período de 30 minutos. Durante essa análise, realizaremos 100 medições de tempo (em milissegundos) e registraremos os resultados em uma tabela. A tabela pode ser estruturada da seguinte forma:

| Medição | Latência (ms) |

|---|---|

| 1 | 20 |

| 2 | 21 |

| 100 | 25 |

Após ter coletado os dados, podemos calcular a média e a mediana da latência, que são medidas estatísticas essenciais. A média é obtida pela soma de todas as latências dividida pelo número total de medições. A mediana, por outro lado, é o valor central que divide a amostra em duas partes iguais.

Em adição aos cálculos estatísticos, podemos criar um gráfico de dispersão, onde o eixo X representa o número de medições e o eixo Y representa a latência associada a cada medição. Este gráfico possibilita a visualização de qualquer padrão na latência ao longo do tempo, ajudando a identificar possíveis picos de congestionamento.

É crucial realizar esse tipo de análise em um ambiente seguro e controlado. Os resultados obtidos podem fornecer informações valiosas para otimização da rede e melhoria na qualidade do serviço. Portanto, a combinação de matemática, probabilidade e estatística não apenas ajuda a entender as variáveis em jogo, mas também orienta as decisões em infraestrutura de redes de computadores.

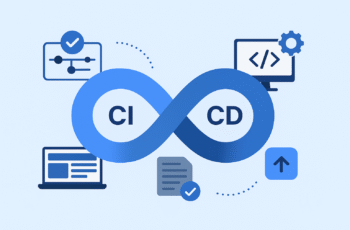

Desenvolvendo um Código Exemplo

No contexto de redes de computadores, é fundamental compreender os conceitos de probabilidade e estatística, os quais podem ser aplicados em diversas situações do dia a dia. Para ilustrar esses conceitos, desenvolvemos um exemplo de código que simula a alocação de pacotes de dados em uma rede usando a distribuição de Poisson. Este código pode ajudar a entender como a teoria se traduz em prática, permitindo aos profissionais aplicar esses conhecimentos em projetos reais.

A seguir, apresentamos uma implementação simples em Python para simular a probabilidade de chegada de pacotes de dados em um servidor. O código utiliza a biblioteca ‘numpy’ para gerar números aleatórios conforme a distribuição de Poisson, possibilitando a simulação de diferentes cenários em uma rede. Aqui está o exemplo:

import numpy as npdef simulate_packet_arrival(rate_lambda, time_period): # Gera o número de pacotes que chegam em um determinado período num_packets = np.random.poisson(rate_lambda * time_period) return num_packets# Configurações de simulaçãorate_lambda = 5 # Taxa média de pacotes por segundotime_period = 10 # Período de 10 segundos# Simula a chegada de pacotesarrivals = simulate_packet_arrival(rate_lambda, time_period)print(f"Número de pacotes recebidos em {time_period} segundos: {arrivals}")No trecho de código acima, a função simulate_packet_arrival calcula a quantidade de pacotes que chegam em um intervalo de tempo definido. A taxa média de pacotes, representada por rate_lambda, é um dos principais parâmetros a ser ajustado, pois afeta diretamente a probabilidade de sobrecarga na rede. Ao executar este programa, os usuários podem observar como diferentes taxas de chegada influenciam o desempenho da rede.

Esse exemplo prático oferece uma visão inicial sobre como a matemática da probabilidade pode ser aplicada diretamente a projetos de redes. Compreender essa relação é essencial para otimizar a alocação de recursos e garantir um desempenho eficiente nas comunicações digitais.

Você também pode se interessar por: Redes de Computadores: Fundamentos e Topologias

Fluxograma: Passo a Passo do Processo

A compreensão dos conceitos de probabilidade e estatística aplicada à rede de computadores pode ser bastante facilitada por meio de um fluxograma. Esse recurso visual permite que os leitores visualizem de maneira clara e organizada as etapas envolvidas no processo, bem como as interações entre diferentes componentes. O fluxograma, portanto, atua como uma ferramenta de aprendizado que sistematiza as informações, facilitando a assimilação e a aplicação desses conceitos em contextos práticos.

Inicialmente, o fluxograma começa com a identificação do problema ou da questão a ser analisada. Essa etapa é crucial, pois define o escopo da análise e orienta as decisões subsequentes. A partir daí, prossegue-se com a coleta de dados, onde são registradas informações relevantes sobre a rede, como tráfego, ocorrências de falhas e desempenho dos dispositivos. A coleta criteriosa desses dados é fundamental para garantir a precisão da análise estatística.

Em sequência, uma das etapas mais importantes é a análise descritiva dos dados, que envolve cálculos de medidas como média, mediana e variância. Essa análise oferece uma visão geral do comportamento dos dados, permitindo identificar tendências e padrões que podem influenciar a performance da rede. Após essa análise inicial, o fluxograma segue direcionando para a aplicação de métodos probabilísticos, os quais permitem modelar a incerteza e prever comportamentos futuros dentro da rede.

Finalmente, o último passo do fluxograma se refere à interpretação dos resultados, onde são feitas recomendações com base nos dados analisados. Essa interpretação é essencial, pois fornece subsídios para a tomada de decisão em relação a melhorias ou ajustes na configuração da rede, tendo como base dados quantitativos e estatísticos. Portanto, esse passo a passo não só organiza o conhecimento, mas também enriquece a aplicação de técnicas de probabilidade e estatística dentro da área de redes de computadores.

Gráficos e Vetores Necessários

A análise eficaz de redes de computadores requer ferramentas que possibilitem a visualização clara de dados, e entre as mais relevantes estão os gráficos e vetores. Os gráficos são representações visuais que revelam tendências, padrões e anomalias em conjuntos de dados, enquanto os vetores permitem uma representação geométrica e dimensional de informações, especialmente útil para descrever o tráfego em uma rede.

Um exemplo prático de gráfico é o gráfico de barras, que pode ser utilizado para ilustrar o número de pacotes transmitidos em uma rede ao longo do tempo. Este tipo de gráfico não apenas facilita a comparação de dados em diferentes períodos, mas também ajuda a identificar picos e quedas na atividade da rede, permitindo que administradores tomem decisões informadas sobre o desempenho e a necessidade de ajustes na infraestrutura.

Outro exemplo relevante é o gráfico de linhas, que pode indicar a variação no tempo de resposta de uma rede. Com um gráfico de linhas, é possível visualizar a latência ao longo de um período, o que é crucial para identificar problemas potencialmente disruptivos. Aqui, a inclusão de vetores pode enriquecer ainda mais a análise. Os vetores podem ser utilizados para representar a direção e a intensidade do tráfego de dados, permitindo que os especialistas em redes visualizem não apenas quanto tráfego está ocorrendo, mas também para onde esse tráfego está se dirigindo.

Dessa forma, a integração de gráficos e vetores na análise de redes de computadores é essencial para a interpretação complexa de dados. Esses instrumentos visuais promovem uma abordagem mais compreensível e acessível à informação, permitindo uma resposta mais rápida e eficiente às demandas e desafios de uma rede. No final, a adoção dessas ferramentas não só torna a análise mais simples, mas também contribui significativamente para a melhoria do desempenho geral da rede.

Resumo e Nota Técnica

O presente artigo abordou a relevância fundamental da matemática, probabilidade e estatística no campo das redes de computadores. Inicialmente, discutimos como a matemática serve como a base para a detecção e correção de erros em transmissões de dados, essencial para garantir a integridade da informação. As técnicas matemáticas aplicadas na codificação de dados são vitais para a eficiência das redes, permitindo a otimização do tráfego e melhor utilização da largura de banda.

Em seguida, analisamos o impacto da probabilidade na gestão de redes de computadores. A probabilidade é utilizada para modelar e prever o comportamento de tráfegos de rede, contribuindo para a criação de algoritmos que ajudam na tomada de decisões em situações de congestionamento ou falhas. As aplicações de modelagem probabilística, como a teoria de filas, são cruciais para otimizar o desempenho e melhorar a experiência do usuário.

A estatística, por sua vez, desempenha um papel essencial na análise de desempenho das redes. Através de técnicas estatísticas, é possível realizar coletas de dados, identificar padrões de uso e avaliar a qualidade da rede. Essa análise estatística permite não apenas monitorar o desempenho em tempo real, mas também prever tendências futuras de utilização, ajudando na identificação de necessidades de expansão ou ajustes na configuração da rede.

Nota Técnica: Ao aplicar os conceitos discutidos, lembre-se das seguintes palavras e conceitos-chave: matemática, probabilidade, estatística, modelagem probabilística, teoria de filas, análise de desempenho. Esses elementos são fundamentais para uma compreensão abrangente e aplicação efetiva dos conteúdos abordados, promovendo o desenvolvimento de redes de computadores mais eficientes e robustas.

Pingback: Rede de Computadores: Materiais e Tecnologias de Processadores Modernos

Pingback: Redes de Computadores: Protocolos, Barramentos e Cabeamento