O Que é Representação de Dados?

A representação de dados é um conceito fundamental no domínio da computação, referindo-se à forma como informações são organizadas e codificadas para que os computadores possam interpretá-las e processá-las. Essencialmente, a representação de dados envolve a conversão de informações do mundo real em uma forma estruturada que os sistemas computacionais conseguem manipular. Essa transformação é crucial, pois permite que dados sejam armazenados, transmitidos e analisados de maneira eficaz.

Os computadores processam dados em formatos binários, onde cada bit representa uma unidade de informação em dois estados possíveis: 0 ou 1. Para que informações mais complexas, como textos, imagens ou vídeos, sejam compreendidas por máquinas, elas devem ser convertidas em representações apropriadas. Por exemplo, textos são frequentemente representados usando códigos como o ASCII ou Unicode, permitindo que caracteres sejam traduzidos para padrões binários. Já imagens podem ser armazenadas em formatos como JPEG ou PNG, onde cada pixel é representado em uma combinação de valores de cor.

A escolha da representação de dados tem um impacto significativo na eficiência das aplicações computacionais. Dados bem representados não apenas otimizam o uso de memória, mas também afetam a velocidade de processamento. Além disso, uma representação adequada permite uma maior precisão na análise e manipulação de dados, contribuindo para a produção de resultados mais confiáveis. É também importante considerar que diferentes aplicações podem demandar diferentes tipos de representação, de acordo com suas necessidades específicas.

Em suma, a representação de dados é uma disciplina essencial dentro da computação que vai além da mera codificação, englobando aspectos que garantem a eficiência e eficácia no tratamento da informação em ambientes digitais.

Tipos de Dados e Suas Representações

A representação de dados é um aspecto fundamental da computação, abrangendo a forma como a informação é digitada, armazenada e manipulado. Em sistemas computacionais, existem vários tipos de dados, cada um com suas características específicas e métodos de representação. Entre os tipos mais comuns estão os dados numéricos, alfanuméricos e binários.

Os dados numéricos são divididos em duas categorias principais: inteiros e números de ponto flutuante. Os inteiros são representados em sistemas binários como sequências de dígitos binários, com a utilização de uma quantidade fixa ou variável de bits. Já os números de ponto flutuante são frequentemente armazenados utilizando o padrão IEEE 754, que facilita a representação de números muito grandes ou muito pequenos, permitindo operações matemáticas mais complexas.

Os dados alfanuméricos incluem letras, números e símbolos, permitindo a utilização de cadeias de texto em uma ampla gama de aplicações. A representação destes dados é comumente feita através de códigos de caracteres, como ASCII ou Unicode. O ASCII utiliza um conjunto limitado de 128 caracteres, enquanto o Unicode expande essa gama para incluir praticamente todos os caracteres de diferentes sistemas de escrita do mundo, permitindo uma representação mais rica e diversificada.

Dados binários são a essência da informação digital, representando tudo em formato de 0s e 1s. Isso inclui imagens, sons e informações textuais. Cada tipo de dado, seja ele numérico, alfanumérico ou binário, possui métodos distintos de codificação que facilitam a sua manipulação e transmissão em um ambiente digital. Esta diversidade nas representações permite que sistemas computacionais operem de maneira eficiente e eficaz, melhorando a interação do usuário e a performance das aplicabilidades tecnológicas.

Sistema Binário e Codificação

O sistema binário é a base fundamental da computação, utilizado para representar todos os tipos de dados de forma eficiente. Em essência, o sistema binário opera com dois dígitos: 0 e 1. Esses símbolos, conhecidos como bits, são a menor unidade de dados dentro de um sistema de computação. Quando combinados, os bits formam grupos chamados bytes, que normalmente consistem em oito bits. A formação de bytes permite a interpretação e manipulação de dados de maneira mais complexa, possibilitando representar uma infinidade de caracteres, números e comandos.

A codificação é um aspecto crítico que permite que dados, representados em formato binário, sejam traduzidos em caracteres legíveis. Um dos sistemas de codificação mais comuns é o ASCII (American Standard Code for Information Interchange), que mapeia caracteres alfanuméricos e sinais de controle para valores numéricos específicos. Por exemplo, a letra ‘A’ é representada pelo número 65 dentro do sistema ASCII. Embora amplamente utilizado, o ASCII é limitado na sua capacidade de representar caracteres de diferentes alfabetos e símbolos, como aqueles encontrados em línguas não-ocidentais.

Para superar as limitações do ASCII, foi desenvolvido o Unicode, que se destina a unificar a codificação de caracteres em uma única norma, permitindo o uso de mais de 143 mil caracteres de diversas linguagens e símbolos. Isso promove uma maior interoperabilidade entre sistemas globais e assegura que os dados sejam visualizados corretamente em diferentes contextos culturais e linguísticos. Com o uso do sistema binário e métodos de codificação como ASCII e Unicode, a computação moderna consegue lidar com a vasta gama de informações necessárias para as interações do dia a dia.

Representação de Números: Inteiros e Reais

A representação de números em um computador é um aspecto fundamental para a execução de cálculos precisos e eficientes. Os números podem ser, de maneira geral, classificados em inteiros e reais. Os inteiros, que são números sem parte decimal, podem ser armazenados em formatos como inteiros com sinal e inteiros sem sinal. A principal diferença entre esses formatos reside na capacidade de representar números negativos. Inteiros com sinal usam um bit para indicar o sinal, permitindo, assim, a representação de ambos os tipos de números.

Por outro lado, os números reais abrangem não apenas inteiros, mas também frações, e sua representação requer uma abordagem mais complexa. O formato mais comum utilizado para representar números reais em computadores é o ponto flutuante. Este formato é baseado na notação científica, onde um número é expresso como o produto de uma fração e uma potência de base 10. Por exemplo, o número 0,156 pode ser representado como 1,56 × 10-1. O ponto flutuante é essencial para cálculos que envolvem uma vasta gama de valores, já que possibilita a representação de números muito grandes ou muito pequenos.

Um dos desafios mais significativos com a representação de números reais é a precisão. Devido às limitações na quantidade de bits disponíveis para armazenar um número, pode ocorrer perda de precisão em cálculos que envolvem operações com números em ponto flutuante. Isso é particularmente relevante em aplicações científicas e financeiras, onde a exatidão é crítica. A escolha dos formatos de representação e a compreensão das implicações desses formatos são, portanto, essenciais para garantir resultados confiáveis em operações computacionais.

Representação de Imagens e Vídeos

O processo de representação de imagens e vídeos no meio digital é fundamental para a manipulação e apresentação desses conteúdos em dispositivos eletrônicos. Esse processo se inicia com a unidade básica de uma imagem digital: o pixel. Cada pixel representa um ponto em uma grade bidimensional, onde diferentes combinações de cor e intensidade estabelecem a imagem que o usuário visualiza. A resolução, por sua vez, refere-se à quantidade de pixels contidos em uma determinada área, geralmente expressa em termos de largura e altura, como 1920×1080. Uma maior resolução resulta em uma maior clareza e detalhe na imagem.

Os formatos de imagem mais comuns, como JPEG e PNG, possuem características específicas que influenciam na qualidade e no tamanho do arquivo. O JPEG é amplamente utilizado devido à sua capacidade de compactação, que reduz o tamanho do arquivo, mas pode resultar em alguma perda de qualidade, especialmente em imagens com detalhes sutis. Por outro lado, o PNG é ideal para imagens que requerem transparência e melhor preservação da qualidade, embora os arquivos tendam a ser maiores. Esta escolha de formato é essencial dependendo do uso da imagem, seja para web, impressão ou armazenamento.

Quando se trata de vídeos, formatos como MP4 e AVI são populares. O MP4 é conhecido pela sua eficiência em compactação, permitindo que os vídeos mantenham uma boa qualidade mesmo com tamanhos de arquivo reduzidos, tornando-o ideal para streaming e distribuição online. O AVI, embora ofereça alta qualidade, geralmente resulta em arquivos de tamanho maior, o que pode não ser ideal para aplicativos que exigem transferências rápidas. A compressão de dados desempenha um papel crucial em ambos os formatos, impactando a qualidade final da imagem e a experiência do usuário ao visualizar conteúdo multimídia. Através da adequada compreensão desses formatos e suas características, é possível maximizar a eficiência na representação de dados visuais.

Representação de Sons e Música

A representação de dados de áudio é um aspecto crucial na computação moderna, especialmente na produção e reprodução de música. O som, que é uma onda acústica, é capturado e convertido em formato digital por meio de um processo chamado digitalização. Esse processo envolve amostragem e quantização, duas etapas essenciais na conversão de um sinal de áudio analógico em digital.

A amostragem refere-se à captura de dados de um sinal de áudio em intervalos discretos. Quanto maior a taxa de amostragem, mais fiel será a reprodução do som original. Para a maioria das aplicações de áudio, a taxa de amostragem comum é de 44,1 kHz, o que significa que o sinal é amostrado 44.100 vezes por segundo. Este padrão é utilizado em CD de áudio e garante que a qualidade do som atenda aos padrões auditivos humanos. Após a amostragem, o próximo passo é a quantização, que atribui um valor numérico a cada amostra, determinando a amplitude do sinal em cada ponto de amostragem.

Os dados de áudio digitalizados são frequentemente expressos em bits por segundo (bps), que indicam a taxa de transferência de dados. Por exemplo, um arquivo de áudio MP3 típico pode ter uma taxa de bits que varia de 128 bps a 320 bps. Este valor influencia diretamente a qualidade do som; taxas de bits mais altas resultam em melhores experiências auditivas, mas também geram arquivos maiores. Formatos de áudio populares como MP3 e WAV apresentam vantagens e desvantagens, onde MP3, sendo um formato comprimido, ocupa menos espaço, enquanto o WAV oferece qualidade superior, preservando mais detalhes do áudio original.

Além disso, a codificação é um aspecto fundamental na representação de sons e músicas. Ela se refere ao processo de transformação dos dados de áudio para formatos que podem ser facilmente armazenados e transmitidos, assegurando que a integridade e a qualidade do som sejam mantidas ao longo do processo. A correta escolha do formato e do método de codificação pode fazer uma diferença significativa na experiência auditiva do usuário.

Armazenamento e Manipulação de Dados

Os dados digitais são fundamentais para o funcionamento de qualquer sistema computacional, e sua representação, armazenamento e manipulação são essenciais para a eficiência e eficiência operativa. Os dispositivos de armazenamento, como discos rígidos (HDDs) e unidades de estado sólido (SSDs), desempenham um papel crucial nesse processo, permitindo que dados sejam retidos de maneira eficaz, segura e acessível. As HDDs utilizam discos magnéticos para gravar as informações, enquanto os SSDs aproveitam a memória flash, resultando em velocidades de leitura e gravação significativamente mais rápidas.

Para gerenciar eficientemente a grande quantidade de dados armazenados, diversas soluções de sistemas de gerenciamento de banco de dados (SGBDs) foram desenvolvidas. Esses sistemas desempenham funções cruciais, como a garantia da integridade dos dados, a realização de análises, e a facilidade de acesso a informações. Exemplos populares de SGBDs incluem MySQL, PostgreSQL, e Oracle, que propõem diferentes abordagens para organização e manipulação de dados, adaptando-se a variados cenários de uso e necessidades dos usuários.

A manipulação e recuperação de dados armazenados não são apenas uma questão técnica, mas também envolvem a aplicação de linguagens de consulta, como SQL. Através dessas linguagens, os usuários podem solicitar, filtrar, e atualizar informações de maneira eficiente, permitindo que dados relevantes sejam acessíveis em tempo hábil. Além disso, as técnicas de indexação são frequentemente aplicadas para aumentar a velocidade de consulta, tornando o processo de recuperação mais ágil e menos dispendioso em termos de tempo de processamento. A organização racional do armazenamento de dados e as técnicas de manipulação apropriadas são, portanto, elementos essenciais para garantir que as informações estejam sempre acessíveis e utilizáveis quando necessário.

Desafios na Representação de Dados

A representação de dados é fundamental para o funcionamento de sistemas computacionais, mas enfrenta diversos desafios significativos que impactam tanto o armazenamento quanto a integridade da informação. Primeiramente, a limitação de espaço de armazenamento é um dos principais obstáculos. À medida que a quantidade de dados cresce exponencialmente, as tecnologias de armazenamento precisam não apenas aumentar sua capacidade, mas também garantir eficiência no uso do espaço disponível. Essa necessidade leva a técnicas de compressão, que, embora reduzam o tamanho dos dados, podem resultar na perda de informação, o que é uma preocupação crítica para qualquer sistema que dependa da precisão dos dados.

Outro desafio relevante está relacionado à precisão e à manipulação de dados. Durante o processamento e a transmissão de informações, existem diversos fatores que podem provocar erros, como a interferência de sinais e a eventual degradação dos dados. Por exemplo, em sistemas de computação, um pequeno erro numérico pode se perpetuar em cálculos complexos, levando a resultados imprecisos e, em alguns casos, culminando em falhas catastróficas. Portanto, a implementação de algoritmos robustos para verificação e correção de erros é essencial para minimizar esses riscos.

Além disso, a representação inadequada de dados pode resultar em ambiguidades que afetam a interpretação correta da informação. Sempre que os dados são codificados em formatos que não são intuitivos ou que carecem de padronização, a compreensão e a análise se tornam mais difíceis, gerando dúvidas tanto para usuários quanto para sistemas automatizados. Em resposta a esses desafios, a comunidade de tecnologia da informação continua a desenvolver soluções inovadoras que visam melhorar a representação de dados, focando em maneiras de equilibrar a eficiência de armazenamento e a integridade da informação, além de garantir que os dados sejam manipulados com a máxima precisão possível.

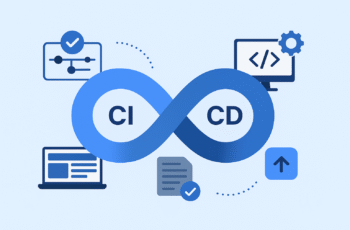

Futuro da Representação de Dados

O futuro da representação de dados é moldado por diversas tendências emergentes que têm o potencial de transformar a maneira como os dados são processados e utilizados em diversas áreas. Entre essas inovações, destacam-se a inteligência artificial (IA), o aprendizado de máquina (AM) e o big data. Essas tecnologias não apenas alteram a forma como os dados são representados, mas também influenciam a interpretação e a utilização dessas informações em contextos cada vez mais complexos.

A inteligência artificial, por exemplo, permite que os sistemas aprendam com grandes volumes de dados, melhorando a precisão das análises e a qualidade da representação dos dados. Com algoritmos de machine learning, é possível identificar padrões e relações que, de outra forma, seriam difíceis de discernir. Isso resulta em formas dinâmicas de representação que se adaptam ao fluxo de informações e às necessidades dos usuários.

Da mesma forma, o advento do big data traz à tona a necessidade de novas abordagens para representar dados em escala. Técnicas tradicionais muitas vezes se mostram inadequadas para lidar com o volume, a variedade e a velocidade desses dados. Portanto, soluções inovadoras de visualização, como gráficos interativos e painéis dinâmicos, foram desenvolvidas para facilitar a compreensão e a análise de dados extensos e complexos. Essas técnicas permitem que os usuários interajam com os dados em tempo real, favorecendo uma tomada de decisão mais ágil e informada.

Em suma, enquanto tecnologias como a IA e o big data continuam a evoluir, a representação de dados também se transformará, refletindo as mudanças nas necessidades e nas práticas de coleta e análise. Essa evolução será crucial não só para o avanço das ciências de dados, mas também para a forma como as empresas e as organizações desenvolvem estratégias e tomam decisões baseadas em dados.