O que é Inteligência Artificial?

A inteligência artificial (IA) é um ramo da ciência da computação que busca desenvolver sistemas capazes de realizar tarefas que, normalmente, requerem inteligência humana. Essa tecnologia é projetada para simular processos cognitivos, como o raciocínio, aprendizado, reconhecimento de padrões e a tomada de decisões. A definição de inteligência artificial abrange uma ampla gama de tecnologias e métodos que capacitam máquinas a resolver problemas, executar tarefas complexas e interagir com o ambiente e os usuários de forma autônoma.

Na sociedade moderna, a importância da inteligência artificial é cada vez mais evidente. A IA está sendo incorporada em diversas áreas, abrangendo setores como saúde, educação, finanças, transporte e recursos humanos. Por exemplo, na área da saúde, sistemas de IA são utilizados para diagnosticar doenças, personalizar tratamentos e até mesmo auxiliar em cirurgias. Na educação, ferramentas baseadas em IA oferecem experiências de aprendizado personalizadas, adaptando-se às necessidades e ritmos dos alunos. Dessa forma, a inteligência artificial tem a capacidade de transformar processos e aumentar a eficiência nas operações de diferentes indústrias.

É importante destacar que a inteligência artificial se diferencia de outras tecnologias digitais por sua capacidade de aprender e adaptar-se ao longo do tempo. Enquanto soluções tradicionais seguem um conjunto de instruções programadas, sistemas de IA utilizam algoritmos avançados e técnicas de aprendizado de máquina para melhorar continuamente suas funções e abordar novos desafios. Assim, a evolução da inteligência artificial é um fenômeno central no desenvolvimento tecnológico atual, com potenciais impactos significativos sobre a economia e a vida cotidiana.

História da Inteligência Artificial

A história da inteligência artificial (IA) remonta à década de 1950, um período crucial que marcou o início dos estudos sistemáticos nessa área. O termo “inteligência artificial” foi utilizado pela primeira vez por John McCarthy em 1956, durante a conferência de Dartmouth, que é frequentemente considerada o ponto de partida formal da pesquisa em IA. Naquele momento, a ideia de máquinas que poderiam simular a inteligência humana parecia promissora e viável.

Os primeiros esforços envolveram a criação de programas que podiam jogar jogos de tabuleiro, como xadrez e damas. Alan Turing, uma figura fundamental na história da computação, contribuiu para essa área com o desenvolvimento do famoso “Teste de Turing”, uma proposta para avaliar a inteligência de uma máquina. Durante as décadas de 1950 e 1960, os pesquisadores começaram a criar sistemas com capacidade limitada de resolver problemas, como o Logic Theorist, desenvolvido por Allen Newell e Herbert A. Simon, que poderia resolver teoremas matemáticos.

Os anos 1970 e 1980 trouxeram um interesse renovado em IA, com a introdução de abordagens baseadas em regras e o desenvolvimento de sistemas especialistas. Esses sistemas eram projetados para emular a tomada de decisão humana em campos específicos, como diagnóstico médico e consultoria financeira. Contudo, as altas expectativas não foram acompanhadas dos avanços tecnológicos necessários, levando a um período de “inverno da IA”, caracterizado pela diminuição do financiamento e do interesse acadêmico.

A revolução da IA moderna começou no início dos anos 2000, com o advento do big data e dos algoritmos de aprendizado de máquina. Pesquisadores e empresas começaram a fazer grandes avanços em áreas como processamento de linguagem natural, visão computacional e reconhecimento de padrões. Figuras como Geoffrey Hinton, Yann LeCun e Yoshua Bengio emergiram como líderes na área, contribuindo significativamente para o que hoje conhecemos como inteligência artificial avançada.

Tipos de Inteligência Artificial

A inteligência artificial (IA) pode ser amplamente classificada em duas categorias principais: IA fraca e IA forte. Cada uma dessas categorias tem suas peculiaridades e aplicações distintas, refletindo o nível de complexidade e autonomia das máquinas. A compreensão dessas divisões é essencial para localizar as diversas tecnologias e sistemas dentro do campo da IA.

A IA fraca, também conhecida como IA estreita, refere-se a sistemas projetados para executar tarefas específicas com eficiência, mas sem ter uma compreensão ou consciência próprias. Esses sistemas funcionam dentro de um escopo limitado e não possuem a capacidade de raciocínio ou aprendizado fora de suas programações. Exemplos clássicos de IA fraca incluem assistentes virtuais como a Siri e o Google Assistente, que são eficientes na execução de comandos predeterminados e na resposta a perguntas, mas que não possuem uma compreensão geral do que significa ser “inteligente”. Outra aplicação da IA fraca pode ser encontrada em algoritmos de recomendação em plataformas de streaming e comércio eletrônico, que analisam comportamentos passados para sugerir produtos ou conteúdos.

Por outro lado, a IA forte, ou IA geral, é uma forma de inteligência que possui habilidades cognitivas semelhantes às humanas. Esse tipo de IA pode compreender, raciocinar e aprender em diferentes contextos, não se limitando apenas a tarefas específicas. Embora a IA forte seja um alvo ambicioso dentro da pesquisa em inteligência artificial, atualmente ainda é uma área de desenvolvimento, considerada futurista. A possibilidade de criação de máquinas com inteligência semelhante à humana levanta questões éticas e filosóficas que continuam a ser debatidas por especialistas

Portanto, a distinção entre IA fraca e forte é importante para compreender as capacidades e limitações dos sistemas de inteligência artificial atuais. Essa compreensão não apenas ajuda em aplicações práticas, mas também orienta a pesquisa futura e o desenvolvimento de tecnologias que buscam uma inteligência mais abrangente.

Aprendizado de Máquina e Redes Neurais

O aprendizado de máquina é uma subdisciplina da inteligência artificial que permite que sistemas computacionais aprendam a partir de dados. Esse método se baseia na ideia de que, em vez de serem programadas explicitamente para realizar tarefas, as máquinas podem identificar padrões e fazer previsões com base em experiências anteriores. As redes neurais, que são inspiradas no funcionamento do cérebro humano, desempenham um papel crucial nesse processo, oferecendo uma estrutura robusta para modelar e resolver problemas complexos.

As redes neurais consistem em uma série de camadas de neurônios artificiais que se comunicam entre si. Esses neurônios são responsáveis por processar as informações, ajustando suas conexões (ou pesos) à medida que aprendem com os dados. Esse ajuste é feito através de algoritmos de aprendizado, que permitem que a rede refine suas previsões com o tempo. Assim, as redes neurais são especialmente eficazes em tarefas como reconhecimento de imagens, processamento de linguagem natural e classificação de dados, onde a complexidade e a diversidade dos dados são significativas.

Existem duas abordagens principais dentro do aprendizado de máquina: o aprendizado supervisionado e o aprendizado não supervisionado. No aprendizado supervisionado, os modelos são treinados usando conjuntos de dados rotulados, ou seja, dados que já vêm com a resposta correta. Essa abordagem é ideal para tarefas onde a saída correta é conhecida e pode ser usada como referência para treinamento. Por outro lado, o aprendizado não supervisionado envolve dados que não têm rótulos ou categorias pré-definidas, permitindo que o modelo identifique padrões e estruturas subjacentes por conta própria. Ambos os métodos têm suas aplicações e utilidades, dependendo do problema a ser resolvido e da natureza dos dados disponíveis.

Exemplo Prático

Para ilustrar a implementação de um simples programa de inteligência artificial, consideraremos um exemplo prático utilizando a linguagem de programação Python. Neste caso, iremos criar um modelo básico de predição de preços de casas utilizando um conjunto de dados conhecido, o Boston Housing Dataset. Este conjunto de dados é frequentemente utilizado para experimentação em projetos de aprendizado de máquina.

Primeiramente, é crucial garantir que o ambiente de desenvolvimento esteja devidamente configurado. As bibliotecas necessárias incluem Pandas, NumPy e Scikit-learn. Você pode instalá-las utilizando o comando pip install pandas numpy scikit-learn no terminal. Após a instalação, será necessário importar os dados para o seu script Python.

A seguir, apresentamos um código básico para carregar e preparar os dados:

import pandas as pdfrom sklearn.model_selection import train_test_splitfrom sklearn.linear_model import LinearRegression# Carregando o conjunto de dadosdata = pd.read_csv('boston_housing.csv')# Separando as variáveis independentes (X) e a dependente (y)X = data.drop('MEDV', axis=1) # 'MEDV' é o preço das casasy = data['MEDV']# Dividindo os dados em conjuntos de treinamento e testeX_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)O próximo passo será treinar o modelo de regressão linear:

# Criando o modelomodel = LinearRegression()model.fit(X_train, y_train)Após o treinamento, podemos fazer previsões utilizando o conjunto de teste:

# Fazendo previsõespredictions = model.predict(X_test)É fundamental ressaltar que, ao realizar tais experimentos, o usuário deve sempre operar em um ambiente seguro, capaz de evitar a manipulação de dados sensíveis. Além disso, este é um exemplo introdutório que pode ser expandido com outras técnicas, como redes neurais e algoritmos mais complexos, conforme o avanço no entendimento de inteligência artificial e suas aplicações.

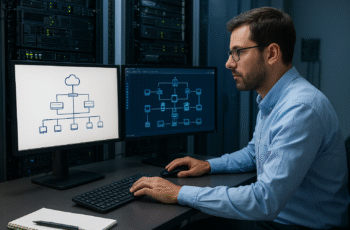

Fluxograma do Funcionamento da IA

A inteligência artificial (IA) opera de maneira altamente sistemática e estruturada, permitindo que sistemas computacionais realizem tarefas específicas de forma autônoma. Um fluxograma que descreve as etapas principais do funcionamento da IA pode ser dividido em várias fases essenciais, cada uma delas desempenhando um papel crucial na tomada de decisões e no processamento de dados. A primeira fase é a coleta de dados, onde informações relevantes são reunidas de diferentes fontes. Esses dados podem ser estruturados ou não estruturados, abrangendo desde números até texto e imagens.

Após a coleta, passamos para a etapa de pré-processamento, onde os dados são limpos e preparados para análise. Essa limpeza é fundamental para garantir que as entradas sejam precisas e relevantes, minimizando erros e viés nos resultados. Na sequência, a etapa de análise de dados utiliza algoritmos e técnicas estatísticas para detectar padrões e extrair insights significativos. Esta análise pode incluir a aplicação de aprendizado de máquina, onde modelos são treinados para reconhecer padrões complexos dentro dos dados.

A próxima fase do fluxograma é a tomada de decisão, onde a IA aplica as aprendizagens adquiridas durante a análise para fazer previsões ou recomendações. Essas decisões podem ser classificadas como ações automáticas ou opções que requerem validação humana. Uma vez que as decisões são tomadas, o sistema de IA produz resultados que podem ser avaliados e ajustados. O ciclo se fecha com o aprendizado, onde os resultados são utilizados para melhorar continuamente os algoritmos e as técnicas empregadas, permitindo que a inteligência artificial se torne mais eficaz ao longo do tempo.

Esse processo iterativo, descrito no fluxograma da IA, reflete a dinâmica e a complexidade que caracterizam o funcionamento dos sistemas de inteligência artificial, destacando a importância de cada etapa na engenharia de decisões autônomas.

Gráficos e Vetores na IA

Os gráficos e vetores desempenham um papel crucial na representação e interpretação de dados dentro do âmbito da Inteligência Artificial (IA). Por meio dessas ferramentas visuais, é possível simplificar conceitos complexos, permitindo que um público mais amplo compreenda as informações essenciais sobre o funcionamento dos algoritmos de aprendizado de máquina e suas aplicações. Gráficos, como diagramas de dispersão e histogramas, são amplamente utilizados para visualizar a relação entre variáveis, enquanto vetores são essenciais para a representação de características de dados em espaços de alta dimensão.

Uma das principais vantagens do uso de gráficos na IA é que eles facilitam a identificação de padrões e tendências que poderiam passar despercebidos em análise puramente numérica. Por exemplo, um gráfico de linha pode ilustrar a performance de um modelo ao longo do tempo, destacando períodos de melhoria ou deterioração. Esses insights visuais são inestimáveis para pesquisadores e profissionais, pois permitem tomar decisões mais informadas sobre o treinamento e a implementação de algoritmos.

Além disso, os vetores são fundamentais na representação de dados em algoritmos de aprendizado supervisionado e não supervisionado. Cada vetor pode encapsular informações multifacetadas sobre um determinado item ou instância, possibilitando a realização de operações matemáticas necessárias para medir similaridades ou diferenças entre os dados. Essa representação é essencial para diversas técnicas de IA, como a classificação e a clusterização, onde a localização de pontos em um espaço vetorial pode determinar os grupos a que pertencem.

Portanto, os gráficos e vetores não apenas facilitam a interpretação de dados complexos, mas também são instrumental na maximização da eficiência dos processos de aprendizado de máquina. A utilização dessas representações visuais contribui significativamente para a evolução contínua da Inteligência Artificial, permitindo avanços em diversas áreas que dependem dessa tecnologia inovadora.

Principais Desafios e Ética na IA

A implementação de inteligência artificial (IA) em diversas áreas levanta uma série de desafios que merecem atenção. Primeiramente, a questão da automação torna-se um tema central, especialmente no que tange ao futuro do trabalho. A substituição de funções humanas pode trazer eficiência, mas também levanta preocupações sobre o desemprego e a requalificação da força de trabalho. As organizações devem equilibrar o potencial da IA para aumentar a produtividade com as implicações sociais e econômicas da automação.

Outro aspecto crítico é o viés algorítmico, que ocorre quando os algoritmos utilizados na IA perpetuam ou até amplificam discriminações existentes. Fontes de dados enviesados podem resultar em decisões injustas em setores como recrutamento, os sistemas de justiça e a concessão de crédito. É imperativo que as empresas desenvolvam modelos transparentes e justos, revisitando constantemente seus dados e algoritmos para mitigar esses riscos. A transparência e a responsabilização são fundamentais para garantir a equidade na aplicação da IA.

A ética na inteligência artificial se entrelaça com a privacidade, uma vez que o uso de grandes volumes de dados pessoais para treinar algoritmos suscita inquietações. A proteção dos dados dos indivíduos deve ser uma prioridade, e as organizações devem estar cientes das legislações vigentes que regulamentam a coleta e o uso destes dados. Práticas éticas no tratamento de informações pessoais não são apenas desejáveis, mas essenciais para ganhar a confiança do público. As discussões sobre os direitos dos indivíduos em relação à sua própria informação são essenciais no debate sobre a responsabilidade social da tecnologia de IA.

Resumo e Conclusão

A inteligência artificial (IA) emergiu como uma área fundamental dentro da ciência da computação, englobando uma variedade de técnicas e abordagens que visam simular a capacidade humana de raciocínio e aprendizado. No decorrer deste post, exploramos aspectos essenciais da IA, incluindo suas definições, os diversos tipos e suas aplicações no mundo contemporâneo. É importante ressaltar que a IA pode ser dividida em inteligência artificial estreita e geral, sendo a primeira a mais comum em uso hoje, com aplicações que vão de assistentes virtuais a sistemas de recomendação em plataformas de streaming.

Discutimos também as técnicas de aprendizado de máquina, uma subárea da IA, que se apoia em algoritmos para analisar dados, aprender com eles e fazer previsões. Dentro desse contexto, abordamos o aprendizado supervisionado e não supervisionado, ambas cruciais para o desenvolvimento de sistemas inteligentes. Além disso, mencionamos a importância do processamento de linguagem natural, que possibilita que as máquinas compreendam e interajam em linguagem humana, criando novas oportunidades em setores como atendimento ao cliente e pesquisa.

Outro ponto relevante enfatizado foi a ética na inteligência artificial. À medida que os sistemas de IA se tornam mais integrados em nossas vidas, surgem também questões sobre privacidade, responsabilidade e viés algorítmico. É fundamental que os desenvolvedores e as organizações considerem esses aspectos ao implementar soluções de IA, garantindo que a tecnologia não apenas beneficie, mas também respeite os direitos dos usuários.

Em conclusão, é evidente que os fundamentos da inteligência artificial são vastos e complexos. A tecnologia, ao mesmo tempo que apresenta desafios, oferece um potencial imenso para transformar a sociedade. Palavras-chave como aprendizado de máquina, processamento de linguagem natural e ética na IA são fundamentais para entender a direção futura desse campo dinâmico.

Como a Administração e Tuning de Banco de Dados Podem Melhorar Seu Desempenho Digital